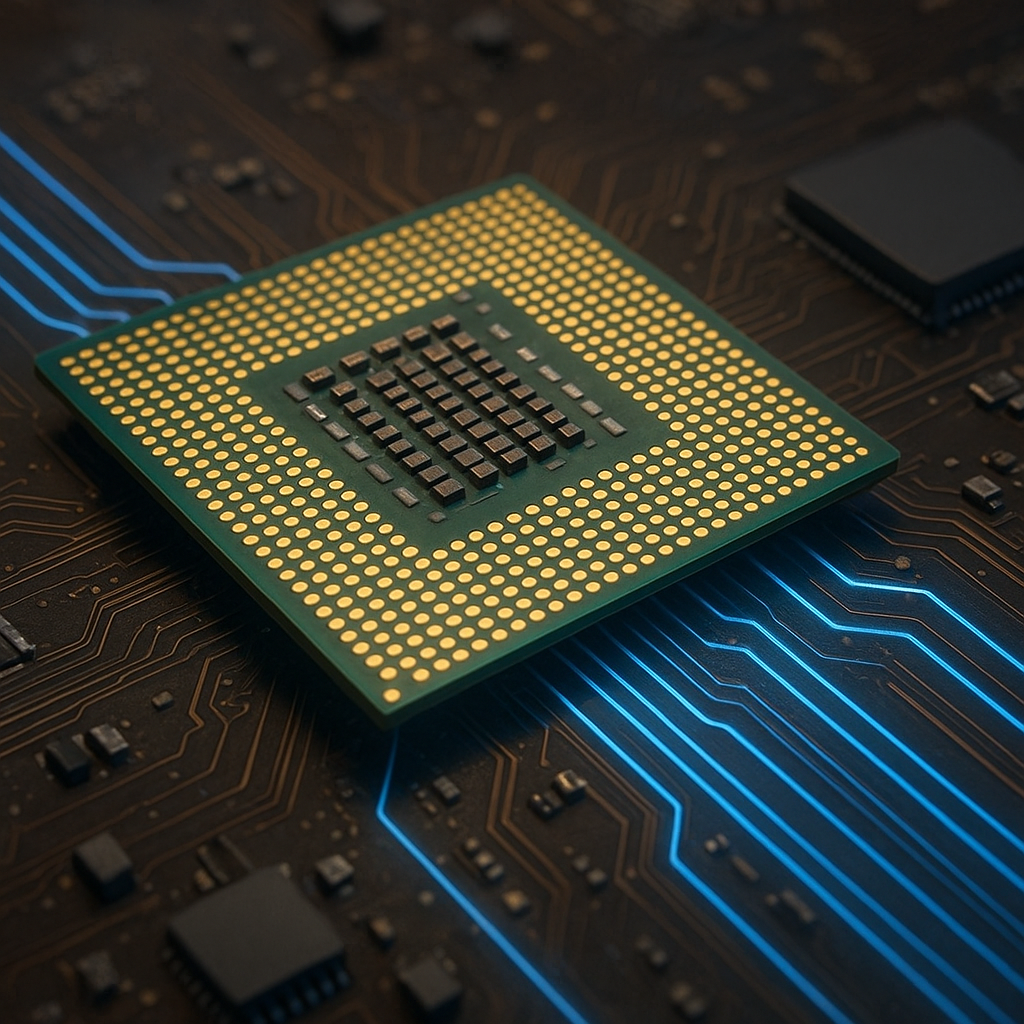

Procesor to serce każdego komputera, odpowiadające za przetwarzanie danych oraz wykonywanie poleceń zapisanych w pamięci. Aby zrozumieć, jak działa ten kluczowy element systemów cyfrowych, warto przyjrzeć się jego budowie, cyklowi maszynowemu oraz technikom optymalizacji wydajności. Ten artykuł wyjaśnia mechanizmy, które pozwalają przeliczać miliardy operacji na sekundę, dzięki czemu możesz lepiej zrozumieć działanie współczesnych urządzeń.

Budowa wewnętrzna procesora

W centrum układu scalonego znajduje się zestaw bloków funkcjonalnych, z których najważniejsze to jednostka arytmetyczno-logiczna, jednostka sterująca oraz zestaw rejestrów. Aby zachować spójność opisu, w tekście wyróżniono najistotniejsze pojęcia:

- CPU – ogólny termin określający jednostkę centralną komputera.

- rdzeń – samodzielna jednostka wykonująca instrukcje, w wielordzeniowych konstrukcjach występuje ich kilka.

- ALU – jednostka arytmetyczno-logiczna, która realizuje operacje matematyczne i logiczne.

- CU – jednostka sterująca, odpowiedzialna za pobieranie, dekodowanie i synchronizację przebiegu instrukcji.

- rejestry – niewielkie, szybkie pamięci wewnętrzne, służące do tymczasowego przechowywania operandów i wyników.

- cache – warstwy pamięci podręcznej zapewniające krótszy czas dostępu niż do pamięci RAM.

- pipeline – technika podziału cyklu procesora na etapy, pozwalająca na równoległe przetwarzanie kolejnych instrukcji.

- taktowanie – częstotliwość zegara, decydująca o szybkości przełączania stanów logicznych.

- architektura – organizacja wewnętrzna i zestaw zasad definiujących budowę oraz sposób współpracy modułów.

- instrukcja – pojedyncze polecenie w kodzie maszynowym, np. dodawanie, skok warunkowy czy odwołanie do pamięci.

We wnętrzu procesora bloki te są połączone za pomocą magistrali, szyn sygnałowych oraz układów synchronizacji. Każdy sygnał zegarowy zmienia stan tranzystorów miliony lub miliardy razy na sekundę, co umożliwia wykonywanie kolejnych kroków cyklu maszynowego.

Cykl maszynowy: pobranie – dekodowanie – wykonanie

1. Pobranie instrukcji

Proces rozpoczyna się od wysłania do jednostki sterującej adresu następnej instrukcji znajdującej się w pamięci podręcznej L1 lub w pamięci głównej. Adres ten jest przechowywany w rejestrze PC (Program Counter). Po odczycie bajtów kodu maszynowego jednostka sterująca zapisuje je do bufora i przygotowuje do dekodowania.

2. Dekodowanie

W tej fazie układ CU interpretuje sekwencję bitów, identyfikując typ instrukcji, liczbę operandów oraz sposób ich adresowania. Rozkaz zostaje przekazany dalej, a sygnały sterujące uruchamiają odpowiednie linie w ALU i rejestrach. W architekturach RISC dekodowanie jest proste i szybkie, gdyż instrukcje mają jednolitą długość.

3. Wykonanie i zapis wyniku

ALU realizuje operację arytmetyczną lub logiczną, korzystając z wartości załadowanych do rejestrów. Po zakończonej obliczeniowo operacji wynik trafia z powrotem do wybranego rejestru lub do pamięci podręcznej. W przypadku operacji skoków lub wywołań podprogramów jednostka sterująca aktualizuje rejestr PC, co pozwala na zmianę kolejności wykonywanych instrukcji.

Optymalizacje wydajności

Współczesne procesory stosują szereg technik mających na celu zwiększenie liczby przetwarzanych instrukcji w jednostce czasu:

- Superskalarność – równoległe wykonywanie wielu instrukcji w tym samym cyklu zegarowym dzięki wielu ścieżkom wykonawczym.

- Hyper-Threading (SMT) – wielowątkowość symetryczna, pozwalająca na współdzielenie zasobów jednego rdzenia przez dwa konteksty wątków.

- Dynamiczne przewidywanie skoków – mechanizmy zgadywania, czy dany rozkaz skoku zostanie wykonany, co minimalizuje puste cykle w pipeline.

- Out-of-Order Execution – wykonywanie instrukcji w kolejności optymalnej dla dostępności zasobów, a nie w porządku zapisu w kodzie.

- Overclocking – podwyższanie częstotliwości taktowania powyżej specyfikacji producenta w celu zwiększenia wydajności kosztem wyższej emisji ciepła.

Dobrze zaprojektowana architektura umożliwia efektywne wykorzystanie jednostek wykonawczych, redukując opóźnienia i minimalizując oczekiwanie na dostęp do danych. Kluczowa pozostaje także hierarchia cache, w której każda kolejna warstwa oferuje większą pojemność, ale wolniejszy czas dostępu.

Przyszłość układów obliczeniowych

Rozwój technologii półprzewodnikowych otwiera nowe możliwości projektowania procesorów. Zmniejszanie wymiarów tranzystorów, integracja układów GPU, akceleratorów sztucznej inteligencji czy modułów FPGA wpływa na wzrost uniwersalności i specjalizacji procesorów. W perspektywie lat pojawią się też zupełnie nowe rozwiązania, takie jak komputery kwantowe czy układy neuromorficzne, które mogą zrewolucjonizować sposób przetwarzania informacji.

Zrozumienie podstawowych zasad działania jednostki centralnej pozwala zarówno entuzjastom, jak i profesjonalistom świadomie dobierać rozwiązania sprzętowe i optymalizować oprogramowanie pod kątem wydajności. Wiedza o strukturze procesora, cyklu maszynowym i technikach przyspieszania obliczeń stanowi fundament projektowania nowoczesnych systemów komputerowych.